Pozn.: Nejsem žádný specialista na disková pole, ale musel jsem se seznámit se základní prací s několika typy diskových polí, takže jsem si dal dohromady určité informace a postupy. Třeba se to bude někomu hodit.

Pozn.: Popis vychází z ONTAP 9.1. Ve verzi ONTAP 9.5 se změnilo rozhraní, ale ne nijak zásadně. Nové rozhraní se objevilo v ONTAP 9.7, ale můžeme si stále vybrat klasickou verzi. V ONTAP 9.8 je již ovšem povinné. Nové rozhraní možná některé věci zjednodušilo, ale nabízí mnohem méně možností. Častěji tak musíme použít CLI.

Pozn.: Nyní je poslední verze ONTAP 9.9.1. Snažil jsem se trochu doplňovat tento článek, ale nakonec jsem se rozhodl rozdělit do samostatných článků. Když jsem zprovozňoval nové pole NetApp AFF A250, tak jsem musel nastudovat řadu základních principů ONTAP. Popis se nachází v NetApp ONTAP komponenty, principy a vlastnosti fungování.

NetApp All Flash FAS (AFF) - základní vlastnosti

Diskové pole NetApp AFF8040 je All Flash FAS systém (tedy FAS, který používá pouze SSD disky) řady 8000 vybavený systémem ONTAP (momentálně je dostupná verze 9.1), dříve se jmenoval Clustered DataONTAP (před verzí 9), jehož součástí je webový OnCommand System Manager pro správu. FAS je navržen jako sdílené úložiště, kdy různé workloady využívají stejné úložiště. Obsahuje mnoho různých vlastností na správu, ochranu dat a ladění výkonu. Umožňuje také pole rozdělit na virtuální části, které se tváří jako samostatné pole a toto virtuální pole můžeme přidělit nějakému subjektu včetně samostatné správy.

FAS pole podporuje současné připojení pomocí blokového přístupu - SAN (Ethernet iSCSI a FCoE, optika Fibre Channel) i souborového - NAS (NFS, pNFS, CIFS/SMB). Má Thin Provisioning bez dopadu na výkon. Speciální inline deduplikaci, který využívá WAFL a přistupuje k datům pomocí ukazatelů, a kompresi. Technologii, která provádí inline data reduction - kompakci (zapisuje více nezaplněných 4kB bloků do jednoho fyzického 4kB bloku). Všechny funkce (jako deduplikace, Thin Provisioning, Snapshot Copies, Virtual Clones, Thin Replication) jsou dostupné pro všechny přístupy SAN (FC, iSCSI) i NAS (CIFS, NFS).

ONTAP podporuje tři typy RAIDu pro agregáty, záleží na použitých discích, jejich typu (NL-SAS, SAS, SSD), velikosti a počtu. RAID4 může použít jeden spare disk a maximálně 14 disků, RAID-DP (Double Parity) může použít dva spare disky a celkově až 28 disků a nový RAID-TEC (Triple Erasure Encoding) podporuje tři spare disky, celkově 29 disků a je navržený pro velké SATA a SSD nad 6TB.

Fyzické úložiště můžeme logicky rozdělit na různé Virtual Storage Controller, čímž oddělíme zákaznické domény, které mají různé svazky, IP adresy, řízení přístupu, apod.

Oficiální dokumentace

- NetApp ONTAP 9 Documentation Center

- ONTAP 9.1 Documentation

- AFF8040 Documentation

- AFF8000 Tech Specs

- My Support - podpora, stahování nových verzí OS a firmware (je potřeba mít vytvořený účet a aktivovaný produkt)

- Installation and Setup Instructions AFF8040 - základní popis zapojení a instalace na 4 stranách

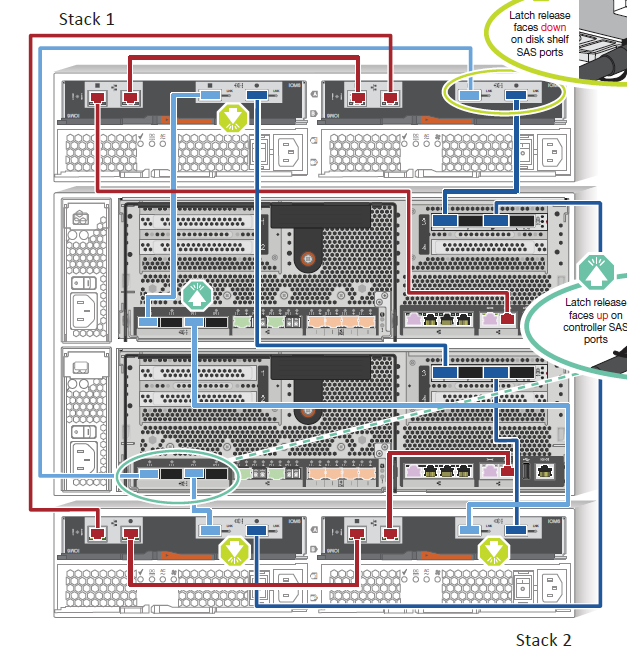

- SAS and ACP Cabling Guide For DS4243, DS2246, DS4486, and DS4246 - podrobný popis připojování polic

- OnCommand Management Software and Management Integration Tools

Konfigurace a zapojení

Konfigurace systému může být různá, záleží na použitých kontrolérech, kartách pro síťovou komunikaci, diskových policích, discích, atd. Zde je ukázka konfigurace, s jakou jsem se setkal.

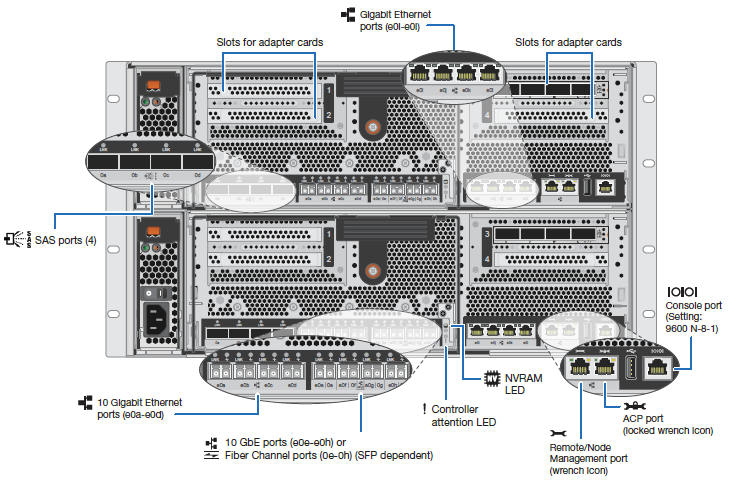

Systém se skládá z Enclosure - 6U vysoké Chassis (skříň) X6227-R6-C, která obsahuje dva kontroléry AFF8040 pro HA (node-a a node-b tvoří dohromady HA Pair) AFF8040-R6. Každý kontrolér je osazený:

- 4x iSCSI porty 10Gbps pro data e0e - e0h

- 8x SAS porty 0a - 0d, 0e - 0h (na přídavné kartě, připojení shelf)

- 4x porty pro cluster interconnect 10Gbps e0a - e0d (využity dva na propojení kontrolérů)

- 6x ethernet port 1Gbps e0i - e0l (můžeme různě nastavit, standardně pro správu virtuálních SVM pro LIF), e0M (cluster nebo node management)

- port na management spojení ACP s diskovým shelfem

K Enclosure se připojuje jedna nebo více diskových polic (Disk Shelf). Zde 2U vysoký model DS2246 osazený 24x SSD disky o kapacitě 3,8TB. Doplněno kompletní licencí na SW. Celková použitelná kapacita 82,5TB.

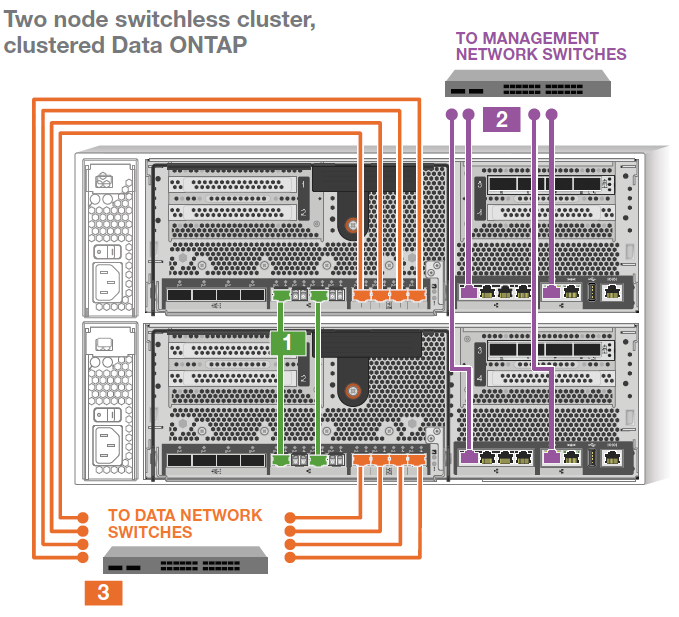

Obrázky z oficiální dokumentace, které popisují připojení kontrolérů do sítě a připojení diskových polic.

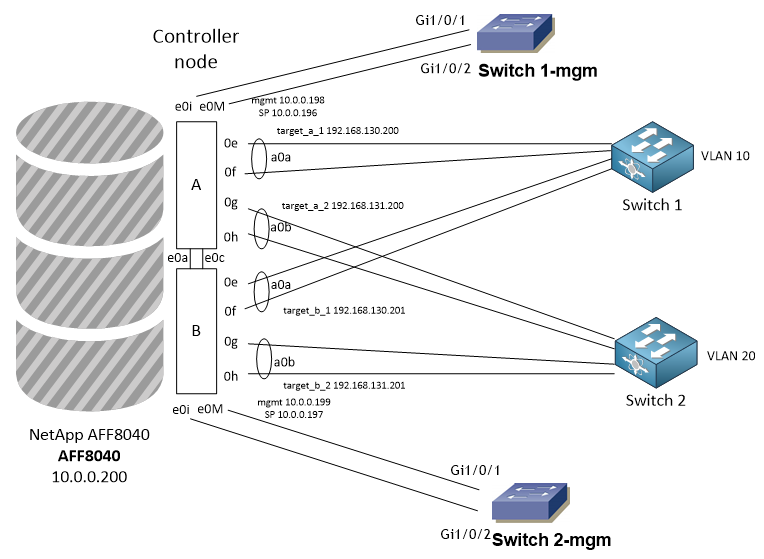

Ukázka možného připojené do sítě. Je zde oddělená LAN síť pro management a datová iSCSI SAN síť.

NetApp MySupport - registrace a AutoSupport

Registrace

Po zakoupení NetApp pole (stejně jako jiné značky) je v podstatě nutné jej zaregistrovat. Na stránce mysupport.netapp.com si úplně na počátku vytvoříme účet, kterým se následně přihlásíme. Pomocí něj provedeme registraci pole (pokud ji již neprovedl dodavatel). Úplně jsem to nepochopil, ale je důležitý název společnosti, na kterou byla registrace provedena, ke společnosti jsou vázány účty a ty pak mají přístup k registrovaným produktům (případně jde ještě o Site/Location). Pro většinu operací se využívá sériové číslo (Serial Number), jsou tam i další možnosti, jako je System ID. Pole AFF8040 se skládá z několika částí a každá má svoje sériové číslo. Jde o dva kontroléry AFF8040-R6 Node-A a Node-B, a potom cluster licence položka SW-2-CL-BASE (Access Key ID, SW-2-CL-LICENSEMGR).

MySupport

Na první záložce My Home (mysupport.netapp.com) máme dashboard, kde si můžeme přidat pár widgetů (pravý horní roh Hide/Show Widgets). Vidíme zde například poslední případy (Cases) na support.

Na záložce Products můžeme registrovat zařízení, vyhledávat již registrovaná zařízení a měnit některé registrované parametry (jako je lokalita). Buď zvolíme položku My Products, kde můžeme vyhledat zařízení podle sériového čísla, ale také třeba hromadně podle Site Name. Pokud neznáme Site Name, tak můžeme použít Manage Products - Site, kde zadáme pouze zemi a zobrazí se nám seznam našich Site a Company Name a k nim seznam produktů.

Záložka Downloads umožňuje stažení software a firmware, takže například obsahuje obrazy pro upgrade pole. Pak máme ještě logické záložky pro zadávání a sledování případů na podporu Cases & Parts. A dokumentace Documentation.

Pod Tools se nachází důležitý odkaz na MyAutoSupport.

AutoSupport

My AutoSupport je webová aplikace, která získává informace z pole pomocí funkce AutoSupport. Informace About My AutoSupport, vlastní aplikace je dostupná na adrese MyAutoSupport, nyní se dá již zkoušet nová verze New My AutoSupport.

Aby pole mohlo využít funkce AutoSupport, tak musí mít skrze Management interface (oba nody i cluster) přístup na NetApp. Standardně se využívá protokol HTTPS. Alternativně SMTP, to je jinak využíváno pro zasílání emailových alertů. Pole pak jednou týdně odesílá souhrnné informace a při určitých událostech alert. NetAppp Support může reagovat a například, když dojde k poruše disku, tak automaticky odesílá nový díl.

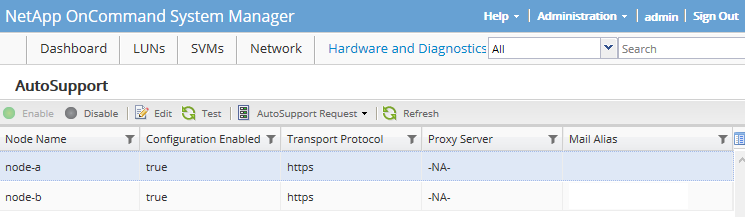

Nastavení AutoSupportu nemá moc možností. V OnCommand System Manager se nastavení nachází pod Hardware and Diagnostics - AutoSupport. Vlastní funkci zde můžeme pouze zapnout a vypnout pro jednotlivé nody. Pro zasílání emailových alertů můžeme nastavit adresu odesílatele, příjemců a poštovního serveru (Mail Hosts). Také můžeme kliknout na tlačítko Test, které vygeneruje emailový alert a událost na NetApp Support (která se automaticky uzavře a dorazí emailem).

Konfiguraci můžeme samozřejmě řešit i přes CLI. Například zobrazení informací o nastavení.

AFF8040::> autosupport show Node State From To Mail Hosts --------------------- --------- ------------- ------------- ---------- node-a enable node-b enable 2 entries were displayed.

My AutoSupport nám, mimo sledování poruch HW, na webu přináší mnoho zajímavých informací o poli, sleduje verze firmware, upozorňuje na konfigurační Best Practices, můžeme nechat vytvářet reporty, apod.

Pozn.: K dispozici je také mobilní aplikace NetApp Support App pro Android, iOS a BlackBerry. Ale moc toho neumí.

Správa FAS pole pomocí systému ONTAP

Správa se může provádět pomocí mgmt_cluster IP adresy 10.0.0.200, buď pomocí webového rozhraní HTTPS nebo příkazové řádky SSH. Případně se můžeme připojit přímo na Service Processor (SP, komponenta kontroleru pro vzdálenou správu a dohled) pomocí SSH. V iSCSI SAN síti jsou použity čtyři IP adresy pro připojování klientů.

OnCommand Unified Manager

Pro podrobnější možnosti dohledu nad zdravím a výkonem jednoho nebo více NetApp FAS polí, můžeme nainstalovat/nasadit (VMware appliance) OnCommand Unified Manager a k němu OnCommand Performance Manager, který se do něj integruje. Tyto nástroje dovolí lepší dohled a sledování vývoje v čase. Můžeme také nastavovat různé události, na které jsme upozorněni emailem.

Nástroje jsou zdarma ke stažení na mysupport.netapp.com - Downloads - Software, kde v sekci OnCommand Unified Manager for Clustered Data ONTAP a OnCommand Performance Manager (Unified Manager Performance Pkg) zvolíme platformu (nejjednodušší je VMware vSphere) a stáhneme aktuální verzi. Návod pro nasazení se nachází v OnCommand Unified Manager - Installation and Setup Guide.pdf.

Oba nástroje byly nahrazeny jedním novým Active IQ Unified Manager.

Termíny pro pole FAS

Kontroléry (řadiče) v poli jsou samostatné, ale můžeme je napřímo síťově propojit a vytvořit HA Pair. Každý řadič je pak uzel (node) clusteru. HA Pair poskytuje odolnost proti chybám (fault tolerance), protože každý node může převzít (take over) řízení, takže můžeme bezvýpadkově provádět upgrady SW a HW údržbu.

- Node - jeden kontrolér v clusteru, oba jsou spolu spojeny pomocí sítě a jsou připojeny k diskovým policím, v OnCommand System Manager - Hardware and Diagnostics - Nodes

- LIF - Logical Interface - IP adresa nebo WWPN s přiřazenými vlastnostmi (role nebo service policy, home port a home node, porty pro failover), pomocí LIF na portu se komunikuje do sítě, LIF běží na přiřazeném node a port (home port a home node), ale v rámci failover se může přesunout na jiný port v rámci Failover Group (neplatí pro SAN LIFs), v OnCommand System Manager - Network - Network Interfaces

- Portset - skupina interfaců (LIF) skrze které komunikuje SAN klient s polem, pomocí něj můžeme omezit dostupné cesty ke klientovi, nastavuje se na Initiator group, v OnCommand System Manager - LUNs - Portsets

- SVM - Storage Virtual Machines (vServer) - slouží k bezpečné izolaci sdíleného virtualizovaného úložiště, fyzické pole můžeme rozdělit na několik virtuálních, What SVMs are, v OnCommand System Manager - SVMs

- Initiator - klient, který se připojuje k LUNu, vyjednává připojení s Target

- Target - cílová adresa diskového pole, přes kterou se Initiator připojuje k LUNu

- Initiator group (iGroup) - určuje, který host může přistupovat k určitému LUNu na storage systému, na poli nám reprezentuje klienta (server), v OnCommand System Manager - LUNs - Initiator Groups

- IQN - iSCSI Qualified Name - iSCSI identifikátor initiatoru nebo targetu,

iqn.1991-05.com.microsoft:server.firma.local - WAFL - WriteAnywhere File Layout - patentovaná technologie NetAppu, která se nachází nad RAIDem a zprostředkovává čtecí a zápisové operace, podporuje velká úložiště, vysoký výkon, rychlé zotavení z chyb a zvětšování prostoru

Komponenty pro vytvoření disku (LUNu) pro server

Z fyzické vrstvy, což jsou fyzické disky v poli, vytváříme několik zapouzdřených logických vrstev, nejprve z disků RAID skupiny (RAID Groups). Jednu nebo více skupin spojujeme do agregátu (Aggregate) a uvnitř agregátu vytváříme řadu svazků (FlexVol Volumes). V každém svazku vytvoříme jeden (nebo i více) LUN.

- Disk - fyzický disk v polici, v OnCommand System Manager - Hardware and Diagnostics - Disks - Inventory

- RAID Group - skupina disků s nastaveným typem RAIDu (NetApp používá vlastní RAID-DP) a dalšími parametry, v OnCommand System Manager - Hardware and Diagnostics - Aggregates

- Aggregate - může se skládat z jedné nebo více RAID Group, na něm nastavujeme bezpečnost, výkon, zálohování, apod., přímo neobsahuje data, přiřazuje se k určitému kontroléru (pokud máme dva, tak to funguje active-passive), proto můžeme vytvořit dva agregáty, kdy je každý přiřazen jinému kontroléru a využijeme výkon obou, v OnCommand System Manager - Hardware and Diagnostics - Aggregates

- Plex - kopie dat, pokud je agregát zrcadlený, tak má 2 plexy (plex0 a plex1)

- Volume - používá se Flexible volume - FlexVol, logický prostor uvnitř agregátu, obsahuje vlastní data, můžeme měnit velikost, něco jako partition z pohledu pole, můžeme mít max. 500 Volumů, v OnCommand System Manager - SVMs - otevřeme SVM - Volumes

- QTree - z pohledu pole jde o něco jako podadresář uvnitř Volumu, je to obdoba jako Volume, ale má omezené vlastnosti (snapshoty můžeme nastavovat pouze na Volume, nepodporuje rezervace prostoru), v OnCommand System Manager - SVMs - otevřeme SVM - Qtrees

- LUN - Logical Unit Number - v rámci Volumu (nebo QTree) můžeme vytvořit jeden (běžně doporučeno) nebo více (pokud jich máme hodně, pak se hodí použít QTree) LUNů, z pohledu pole jde o soubor uvnitř Volume. Z pohledu klienta (serveru) jde o disk, který publikujeme serveru (Initiatoru). Reprezentuje individuálně adresovatelné logické zařízení. V OnCommand System Manager - LUNs - LUN Management

Doporučení pro vytváření Volume a LUN

- můžeme využít Thin Provisioning, což nám může ušetřit hodně místa, ale tím dochází k Over-provisioning (přidělíme více místa, než je dostupné), takže musíme pečlivě monitorovat zaplnění agregátu (fyzického prostoru)

- Volume by měl být větší než LUN, záleží na využívání snapshotů, ale minimálně o 5 % nebo můžeme povolit Autogrow o 10 % (resize automatically)

- agregát (Aggregate, případně Tier) bychom měli zaplnit jen do 80 % pro optimální fungování pole, maximum 90 %, pak již mohou nastat problémy

- je dobré sledovat (případně upravit defaultní hodnoty v CLI) zaplnění LUN, Volume, Aggregate

Přidání Spare disku

Větší změny, jako je přechod na ADP (pokud jej nepoužíváme), vyžadují novou inicializaci, a tedy přijdeme o data. Nemůžeme také odebrat disk, aniž bychom přišli o dostupnost RAID/Spare (což naše staré pole NetApp E2760 umí).

Zjistili jsme, že když bylo naše pole konfigurováno, tak byly datové agregáty vytvořeny bez Spare disků. Řešení by bylo přidat nové fyzické disky, ale není kam. Takže jedině odsunout všechna data a nově vytvořit. Napadla mne ještě další možnost, která se úspěšně povedla.

- přesunout všechny Volume na jeden Aggregate

- prázdný agregát smazat

- pomocí CLI vytvořit nový agregát a počet disků dát o 1 menší

- agregát se vytvořil a korektně zobrazuje Spare disky

- potom všechny Volume přesunout na nový agregát a vše zopakovat

Ukázka příkazů, které v mém případě fungovaly. První je vytvoření agregátu, druhé vymazání Spare disku.

storage aggregate create -aggregate aggr_data2 -diskcount 23 -node node-b storage disk zerospares -owner node-b

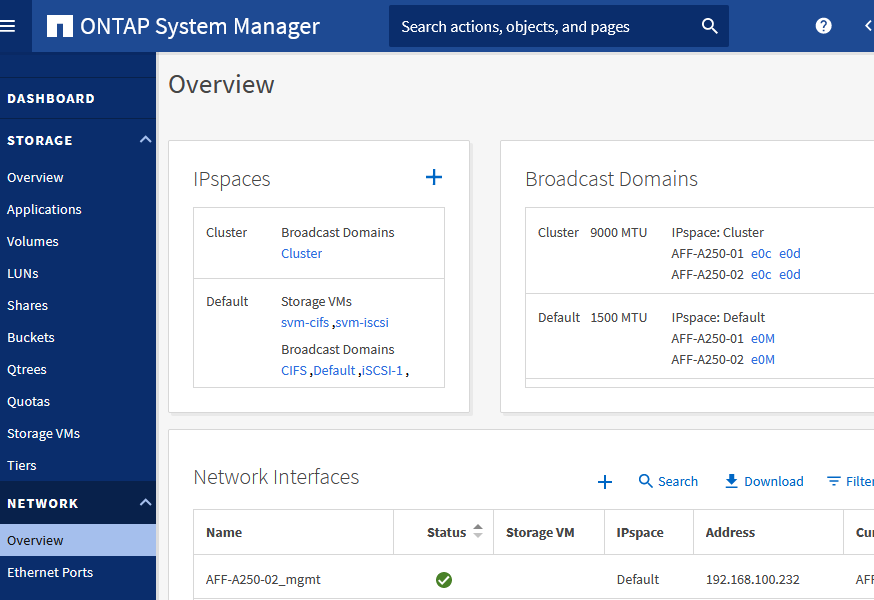

Doplněno ONTAP 9.8 - sítě

Nové GUI je hodně přepracované. Řada věcí je zjednodušena a skryta, takže mnoho věcí musíme nastavit pomocí CLI. Když konfigurujeme nové pole, tak se různé věcí umí nastavit automaticky (ale třeba IP adresu pro SP nenastavíme, takže musíme do CLI, jinak se nám logují chyby, že nemáme adresu). Můžeme použít Prepare Storage, což nám má optimálně nastavit disky, vytvořit RAID Groupy a agregáty (asi se jim v GUI říká Tiers). Je zde i průvodce pro Configure Protocols, což je vlastně vytvoření Storage VM. SVM vytváří také LIF, ale často si musíme ručně připravit.

Když nastavujeme nové pole, nebo přidáváme nové SVM, třeba pro jiný protokol, tak jsou důležité dva termíny související se sítěmi (a dříve jsem je neřešil).

- IPspaces

- adresní prostor

- umožňuje rozdělit diskové pole pro více organizací, které mohou využívat stejné IP adresy

- pro jednu organizaci se doporučuje využívat pouze jeden IPspace

- Storage VM (SVM) se zařazuje do jednoho IPspace (nelze přesunout) a udržuje vlastní routovací tabulku

- neprobíhá žádné směrování cross-SVM nebo cross-IPspace

- automaticky je vytvořen IPspace Cluster, kam jsou zařazeny cluster porty a probíhá komunikace nodů (internal private cluster network), a Default pro vše ostatní, je zde i správa pole a nodů

- pro každý IPspace se vytváří systémové SVM

- Broadcast Domains

- slouží k seskupování síťových portů, které patří do stejné L2 sítě (mohou spolu komunikovat po L2)

- porty ve skupině používá SVM pro datový provoz nebo správu (nebo cluster)

- Broadcast Domain je zařazena do IPspace

- automaticky je vytvořena Broadcast Domain Cluster a Default, případně další Default-1, atd.

- port v Broadcast Domain (může být zařazen pouze do jedné) používá LIF

- spolupracuje s Failover Groups a subnets (umožňuje, řídí a zabezpečuje chování LIF Failover)

V ONTAP 9.8 se za určitých situací vytváří nové Broadcast Domains automaticky. Ručně můžeme IPspace i Broadcast Domains vytvářet nebo editovat v NETWORK - Overview.

Než se pustíme do vytváření SVM, tak si musíme připravit porty. Například pokud chceme některé porty agregovat (spojit) do PortChannelu, tak vytvoříme Link Aggregation Group (NETWORK - Ethernet Ports). Volíme porty, mód (nejlépe LACP, v GUI nejde později měnit, musí se případně smazat a znovu vytvořit) a metodu rozvažování. U iSCSI portů chceme nastavit MTU 9000. U jednotlivých portů vidíme nastavenou hodnotu, tak nemůžeme měnit. Nastavení se provádí na Broadcast Domains (NETWORK - Overview). Asi je lepší si připravit nové Broadcast Domains (pokud jde o nové sítě).

Při vytváření SVM (STORAGE - Storage VMs) zadáváme adresy (vytváříme) Network Interface, tedy LIF. Zadáváme IP adresu a masku, volitelně bránu. Pokud daný subnet již existuje, tak se přiřadí odpovídající Broadcast Domain. Jinak se použije defaultní (nejsem si jist, v jaké chvíli se k portům vygenerovaly nové Broadcast Domains). Důležité je zvolit správnou Broadcast Domains, kde máme volné porty (Home Port). K nim se vytvoří (přiřadí) LIF. Pokud port nebude zařazen do žádné Broadcast Domain, tak se nepoužije.

Při špatném zadání dostaneme chybu:

[Job 98] Job failed: LIF "lif_svm-iscsi_595" could not be created because no suitable home port could be found. Use the "network port show -node AFF-A250-01" command to review available home ports, then try the command again with the "-home-port" argument specified.

Operace s diskem (LUNem)

Základní komponenty

Když nově instalujeme pole, tak musíme vytvořit několik objektů, které budeme dále využívat a většinou nepotřebujeme přidělávat další. Jejich vytvoření se zde nebudeme věnovat.

- agregáty vytvořené na určitých discích s RAID-DP a přiřazené ke kontroleru

- jedno SVM s protokolem iSCSI

- jeden portset typu iSCSI, který obsahuje všechny 4 porty (cesty)

Pravidla pro pojmenovávání

Myslím, že na začátku je dobré si stanovit určitý standard, jak budeme pojmenovávat objekty, které budeme na poli běžně vytvářet. Tak abychom z názvu poznali, o jaký jde objekt a k čemu patří. Například:

- LUN - jméno-serveru_lun_číslo, příklad

server1_lun_1 - Volume - jméno-serveru_vol_číslo, příklad

server1_vol_1 - Initiator Group - jméno-serveru_igroup, příklad

server1_igroup

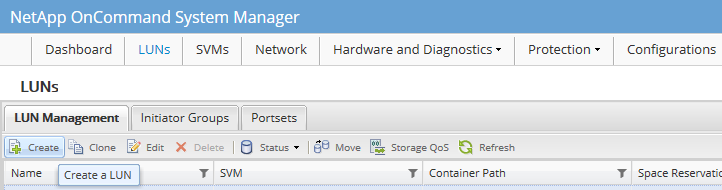

Vytvoření LUNu a namapování na server

- připojíme se na webové rozhraní pole OnCommand System Manager

- v hlavním menu klikneme na LUNs a jsme na záložce LUN Management

- klikneme na tlačítko Create, zvolíme naše SVM, spustí se průvodce

- zadáme logické jméno pro LUN a případně popis, zvolíme typ OS a velikost, klikneme Next

- můžeme použít již existující Volume, ale standardně vytvoříme nový na zvoleném agregátu, klikneme Next

- pokud již máme vytvořenu skupinu pro náš server, tak ji vybereme, jinak klikneme na Add Initiator Group pro vytvoření nové skupiny

- zadáme jméno skupiny, můžeme použít IQN Initiatoru, ale spíše jméno serveru, zvolíme typ OS, protokol, portset a na záložce Initiators vybereme nebo zadáme nově IQN Initiatoru (zkopírujme z klienta), klikneme na Create

- zaškrtneme vytvořenou iGroup a volitelně zadáme LUN ID, klikneme Next

- na závěr můžeme volitelně nastavit QoS, klikneme Next

- prohlédneme si shrnutí zadaných parametrů, dalším kliknutím na Next se již vše vytvoří

Smazání LUNu na NetApp poli

- připojíme se na webové rozhraní pole OnCommand System Manager

- v hlavním menu klikneme na LUNs a jsme na záložce LUN Management

- klikneme na LUN pravým tlačítkem a zvolíme Offline

- klikneme na LUN pravým tlačítkem a zvolíme Delete

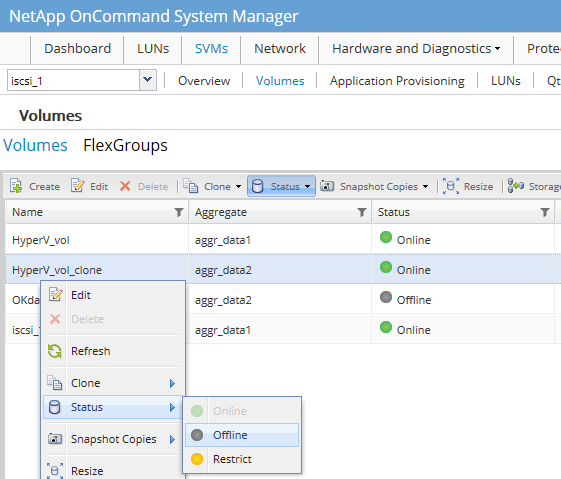

Zobrazení a smazání Volume

Smazání Volume nám smaže i všechny obsažené LUNy a většinou chceme provést toto a ne pouze smazat LUN.

- připojíme se na webové rozhraní pole OnCommand System Manager

- v hlavním menu klikneme na SVMs a rozklikneme vybrané SVM

- přepneme se na záložku Volumes

- klikneme na Volume pravým tlačítkem a zvolíme Status - Offline, potvrdíme, že chceme odpojit

- klikneme na Volume pravým tlačítkem a zvolíme Delete, potvrdíme smazání (včetně všech LUNů)

Zvětšení velikosti LUNu

- připojíme se na webové rozhraní pole OnCommand System Manager

- v hlavním menu klikneme na LUNs a jsme na záložce LUN Management

- klikneme na LUN pravým tlačítkem a zvolíme Edit

- zadáme novou velikost a klikneme Save and Close

- potvrdíme upozornění

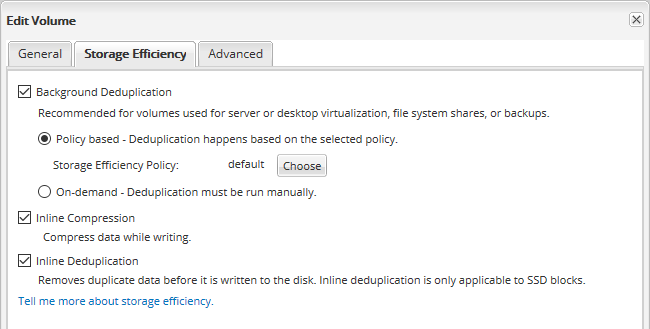

Zapnutí Background Deduplication

Pozn.: Od ONTAP 9.3 běží volume-level background deduplication automaticky díky předdefinované AFF politice auto. Není potřeba plánovat úlohu, jak je popsáno níže.

NetApp se u FAS polí chlubí velmi dobrou deduplikací. Standardně se používá Inline Compression a Inline Deduplication, které se uplatňují při zápisu. Pro řadu typů svazků (virtualizace, zálohy, souborový server) doporučuje NetApp zapnout ještě Background Deduplication, kterou můžeme naplánovat v pravidelných intervalech, a provede deduplikaci na uložených datech. Nastavuje se na svazek (Volume).

- připojíme se na webové rozhraní pole OnCommand System Manager

- v hlavním menu klikneme na SVMs a rozklikneme vybrané SVM

- přepneme se na záložku Volumes

- klikneme na Volume pravým tlačítkem a zvolíme Edit

- přepneme se na záložku Storage Efficiency, zaškrtneme Background Deduplication a zvolíme politiku

- klikneme na Save and Close

Komentáře

Zatím tento záznam nikdo nekomentoval.